Эмоции человека картинки: красивые картинки (100 фото) • Прикольные картинки и позитив

%d1%8d%d0%bc%d0%be%d1%86%d0%b8%d0%b8 PNG рисунок, картинки и пнг прозрачный для бесплатной загрузки

green environmental protection pattern garbage can be recycled green clean

be careful to slip fall warning sign carefully

blue series frame color can be changed text box streamer

дизайн логотипа bc значок буквы b

hand painted chinese style pine ink ink graphics can be combined hand painted pine chinese style

в первоначальном письме векторный дизайн логотипа шаблон

год до н э письмо логотип

Золотая буква b логотип bc письмо дизайн вектор с золотыми цветами

be careful warning signs warning signs be

год до н э письмо логотип

логотип bc

toyota 86 вектор синий элегантный дизайн

86 год лента годовщина

toyota 86 лайн арт автомобиль

номер 86 золотой шрифт

текстура шрифт стиль золотой тип число 86

№ 86 логотип который выглядит элегантно и присоединиться

3d числа 86 в круге на прозрачном фоне

логотип готов использовать год до н э

86 лет юбилей празднования вектор шаблон дизайн иллюстрация

сложный современный дизайн логотипа с биткойн символами и буквами bc

буква bc 3d логотип круг

bc beauty косметический логотип дизайн вектор

86 летний юбилей векторный дизайн шаблона иллюстрация

asmaul husna 86

глюк номер 86 вектор на прозрачном фоне

b8 b 8 письма и номер комбинации логотипа в черном и gr

toyota 86 серебряный векторный дизайн

чемпион по шоссейным гонкам 86 в исполнении экспертов Беги быстро или умри классика

начальный bc алфавит дизайн логотипа шаблон вектор

почерк асмаул хана номер 86

черный градиент 3d номер 86

черный градиент 3d номер 86

86 летие векторный дизайн шаблона иллюстрация

86 летний юбилей векторный дизайн шаблона иллюстрация

абстрактный вектор 3d рендеринг цифра 86 номер редактируемый с прозрачным фоном

have electricity prohibit be careful be

86 мультяшная сова голова наклейка логотип для dft печать скачать бесплатно

год до н э письмо логотип

86 й годовщине векторный дизайн шаблона иллюстрация

gambar waisak 2022 png dan happy vesak day 2566 be

витамин d1 значок логотип золотая капля щит защита медицинский фон здоровье векторная иллюстрация

pop be surprised female character

элегантный золотой стильный дизайн удостоверения личности шаблон vol 86 вектор

Векторный шрифт алфавит номер 86

золото смешанное с зеленым в 3д числах 86

год до н э письмо логотип

в первоначальном письме векторный дизайн логотипа шаблон

be careful warning signs warning signs be

break split orange be

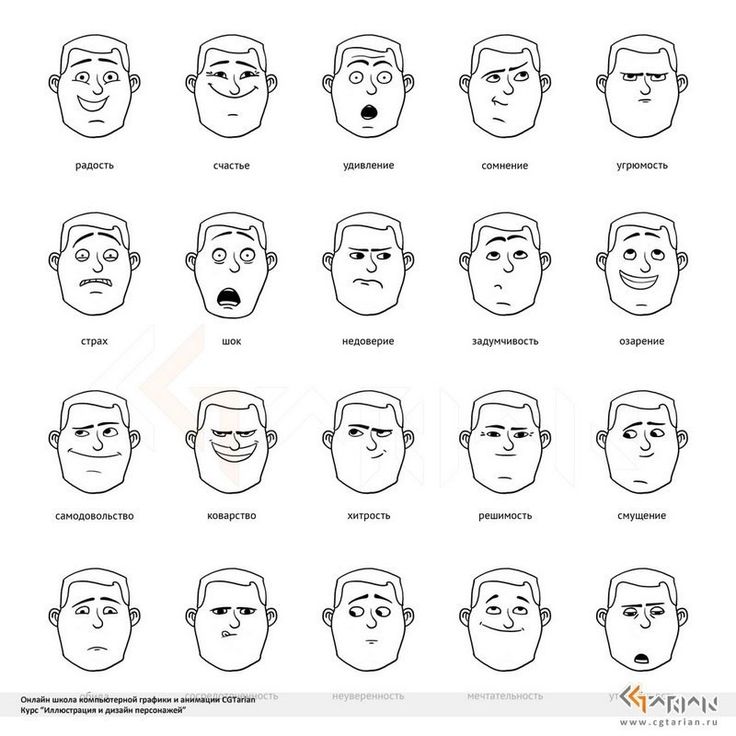

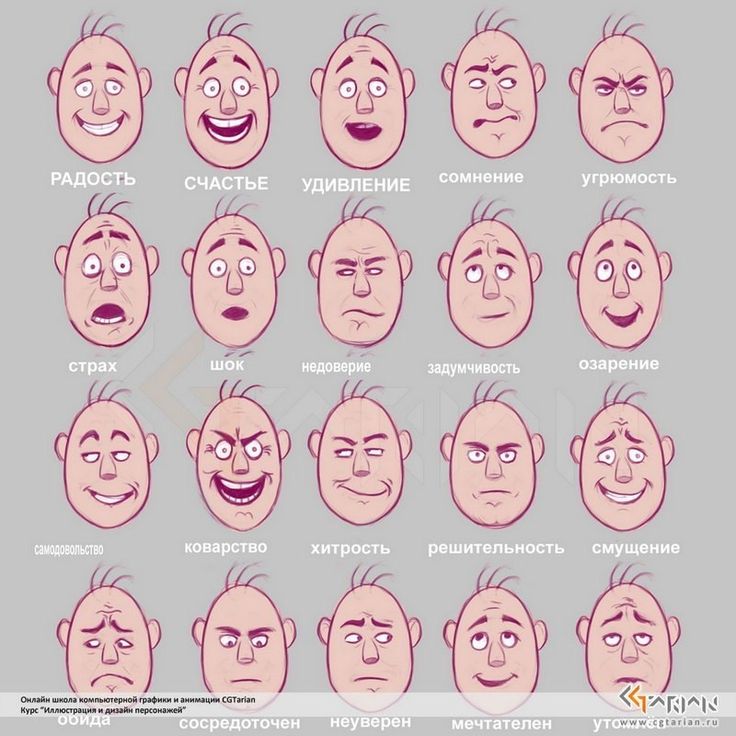

Эмоции в картинках

Очень важно для познания жизни уметь разбираться в чувствах и эмоциях других людей. Именно с такой целью создали карточки и изобразили на них различные эмоции в картинках для детей.

Именно с такой целью создали карточки и изобразили на них различные эмоции в картинках для детей.

И так, что же собой представляют эмоции в картинках?

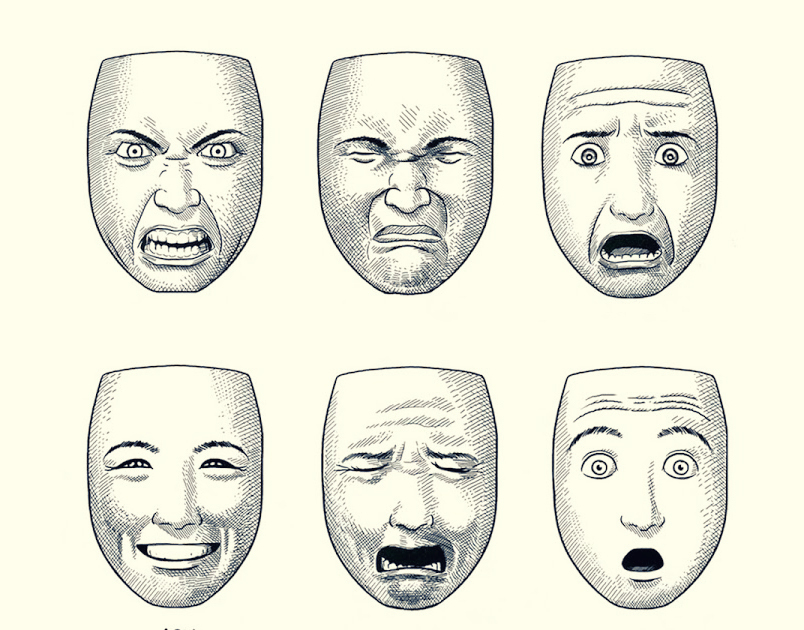

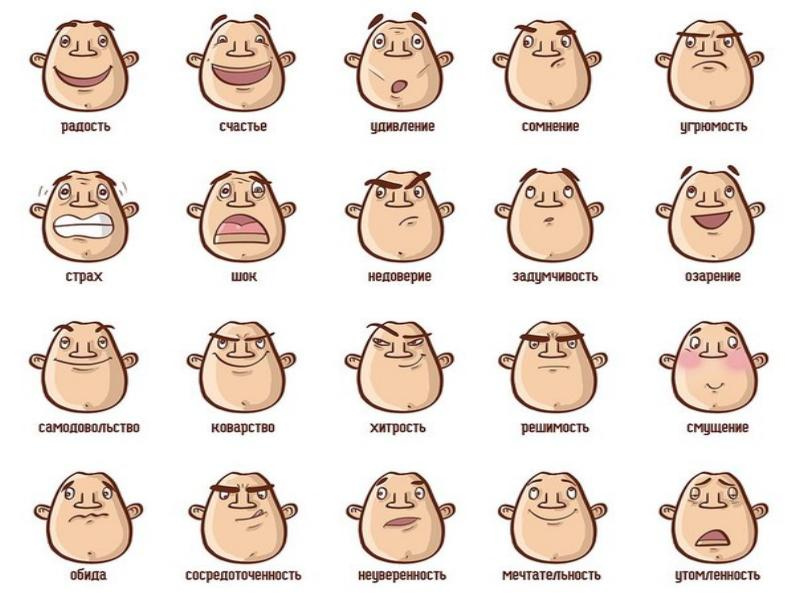

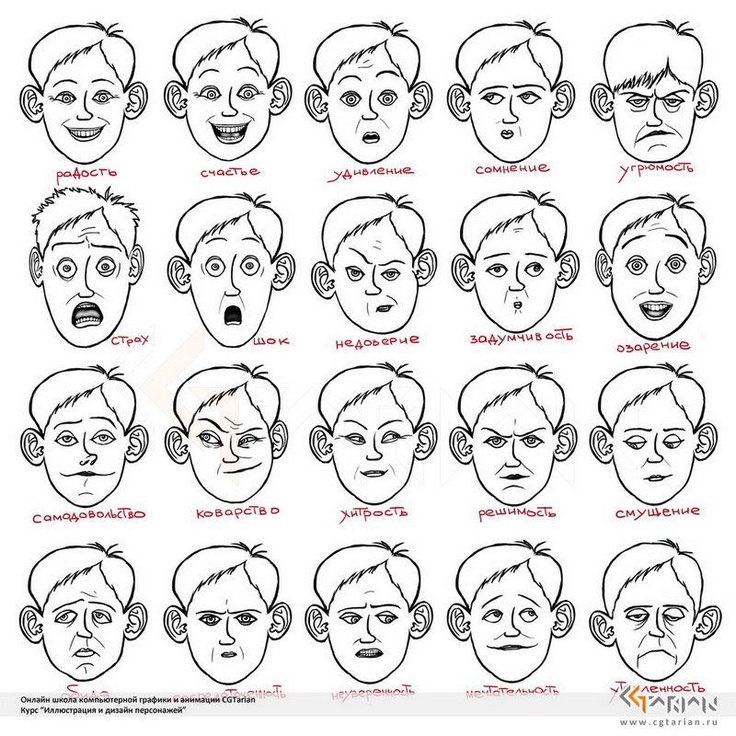

На каждой карточке изображены эмоции человека в картинках. Это может быть гнев, грусть, отвращение, обида, скука, страх, стыд, удивление, восхищение, радость, интерес, удовольствие.

Каждая карточка состоит из двух сторон, с одной из которых изображена картинка, например, с улыбающимся ребенком. А с другой стороны – описание изображенной эмоции.

По таким карточкам можно начинать заниматься с ребенком, которому уже исполнилось полгода. Просто показывайте малышу большую картинку и называйте изображенную на ней эмоцию.

С детками, начиная с двухлетнего возраста, можно просто ограничиться чтением эмоций на карточках. А можно устроить занятия в виде игры. Например, проводим беседу-дискуссию о том, какие эмоции бывают, как их определить. А затем придумываем целую ситуацию, случившуюся с изображенным крохой. С таким же успехом можно на определенную эмоцию вспомнить сказки или рассказы, в которых герои испытывают эту же эмоцию.

Для детей постарше, которым уже исполнилось четыре года, можно использовать разрезные карточки-картинки с изображением эмоций. Это что-то наподобие пазлов. Каждое лицо состоит из трех частей, отличающихся друг от друга по размеру. Задача ребенка в том и заключается, чтобы их соединить правильно между собой и получить определенное выражение лица. А ведь это не так то просто сделать! Ведь для каждого лица свойственны определенные изгибы бровей, губ, форма носа. А после того, как ребенок успешно справиться с поставленной перед ним задачей, можно обсудить ту или иную эмоцию.

Для детей пяти – шести лет уже можно применять карточки со схематическим изображением эмоций, в которых ребенок подбирает пиктограммы к каждой эмоции, изображенной на данном рисунке. Также применяют карточки с пустыми кружками, в каждом из которых можно нарисовать свое лицо с разными эмоциями. Например, в одном кружке – радостное лицо, в другом – грустное лицо.

Такие карточки применяют при занятиях с детьми в детских садах, а также в центрах раннего развития. При возникшем желании есть возможность скачать картинки-эмоции с моего сайта и заниматься по ним дома.

При возникшем желании есть возможность скачать картинки-эмоции с моего сайта и заниматься по ним дома.

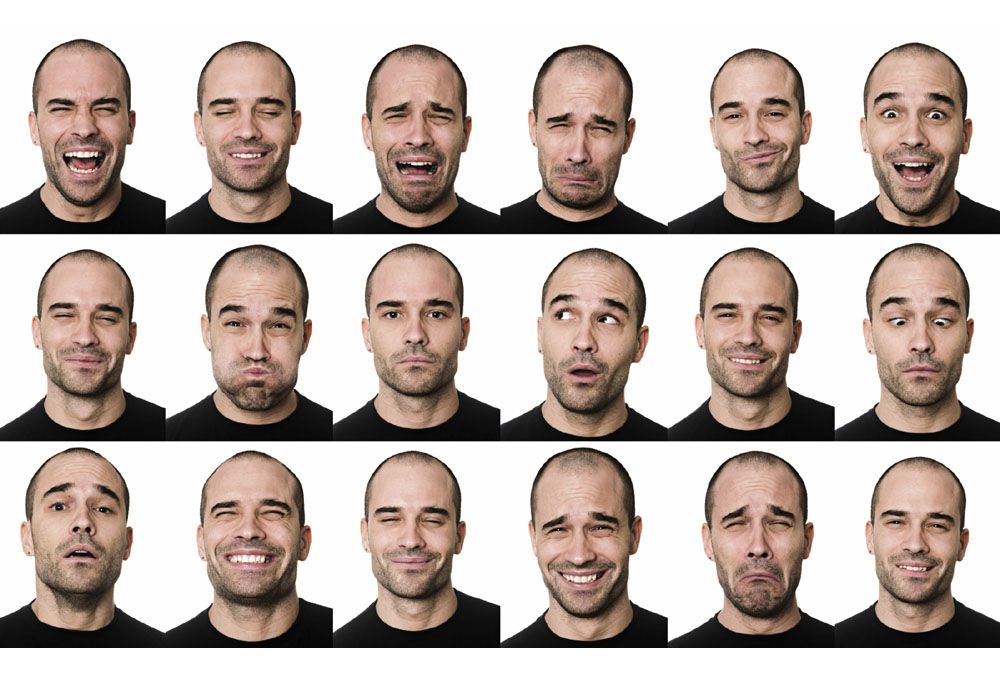

Перед Вами представлены различные варианты карточек, картинок, рисунков и плакатов с различными эмоциями человека. Все материалы можно скачать бесплатно:

Содержание

- Подборка материалов по теме

- Цветные фото-картинки

- Черно-белый вариант с подробным описанием

Цветные фото-картинки

Черно-белый вариант с подробным описанием

Эмоция интерес, а также описание к этой эмоции:

Эмоция гнев и описание к ней:

Грусть:

Обида:

Эмоция отвращение:

Эмоция радости в картинках для детей с описанием:

Скука:

Страх:

Стыд:

Удовольствие:

Восхищение:

Карточки с кружочками, выражающие различные эмоции, к четвертому набору карточек Вы можете самостоятельно подобрать эмоции и подрисовать их вместе со своим ребенком:

Плакат с эмоциями смешного человечка:

Герои различных детских сказок, выражающие эмоции:

Красная шапочка – радость, мальчик злость:

Все эти картинки с эмоциями и плакаты Вы можете скачать одним файлом здесь.

Искусственный интеллект неверно истолковывает человеческие эмоции

Ирэн СуосалоТехнологии

Нет убедительных доказательств того, что выражение лица раскрывает чувства человека. Но крупные технологические компании хотят, чтобы вы верили в обратное.

Автор: Кейт Кроуфорд . было 1967, и Экман слышал, что народ форе с Окапы был настолько изолирован от всего мира, что они были бы его идеальными подопытными.

Как и западные исследователи до него, Экман приехал в Папуа-Новую Гвинею, чтобы получить данные от местного населения. Он собирал доказательства, подтверждающие спорную гипотезу: все люди демонстрируют небольшое количество универсальных эмоций или аффектов, которые являются врожденными и одинаковыми во всем мире. На протяжении более полувека это утверждение остается спорным среди психологов, антропологов и технологов. Тем не менее, это стало отправной точкой для растущего рынка, стоимость которого к 2024 году оценивается в 56 миллиардов долларов. Это история о том, как распознавание эмоций стало частью индустрии искусственного интеллекта, и о связанных с этим проблемах.

Это история о том, как распознавание эмоций стало частью индустрии искусственного интеллекта, и о связанных с этим проблемах.

Когда Экман прибыл в тропики Окапы, он провел эксперименты, чтобы выяснить, как форе распознают эмоции. Поскольку у форе были минимальные контакты с жителями Запада и средствами массовой информации, Экман предположил, что их признание и демонстрация основных выражений докажет, что такие выражения были универсальными. Его метод был прост. Он показывал им карточки с выражением лица и смотрел, описывают ли они эмоцию так же, как он. По словам самого Экмана, «все, что я делал, это показывал забавные картинки». Но у Экмана не было опыта ни в истории, ни в языке, ни в культуре, ни в политике. Его попытки провести свои эксперименты с флэш-картами с помощью переводчиков потерпели неудачу; он и его испытуемые были измотаны процессом, который он описал как выдергивание зубов. Экман уехал из Папуа-Новой Гвинеи, разочарованный своей первой попыткой кросс-культурного исследования выражения эмоций. Но это будет только начало.

Но это будет только начало.

Сегодня инструменты распознавания аффектов можно найти в системах национальной безопасности и в аэропортах, в образованиях и стартапах по найму, в программном обеспечении, предназначенном для выявления психических заболеваний, и в полицейских программах, которые утверждают, что предсказывают насилие. Утверждение, что внутреннее состояние человека можно точно оценить, анализируя его лицо, основано на сомнительных доказательствах. Систематический обзор научной литературы о выводе эмоций из движений лица в 2019 году, проведенный психологом и нейробиологом Лизой Фельдман Барретт, показал, что нет надежных доказательств того, что таким образом можно точно предсказать чье-то эмоциональное состояние. «Невозможно уверенно сделать вывод о счастье по улыбке, гневе по хмурому взгляду или печали по хмурому взгляду, как это пытаются сделать многие современные технологии, применяя то, что ошибочно считают научными фактами», — заключает исследование. Так почему же идея о том, что существует небольшой набор универсальных эмоций, легко интерпретируемых по лицу человека, стала настолько популярной в области ИИ?

Так почему же идея о том, что существует небольшой набор универсальных эмоций, легко интерпретируемых по лицу человека, стала настолько популярной в области ИИ?

Чтобы понять это, необходимо проследить сложную историю и мотивы развития этих идей задолго до того, как инструменты обнаружения эмоций ИИ были встроены в инфраструктуру повседневной жизни.

Идея автоматического распознавания эмоций столь же привлекательна, сколь и прибыльна. Технологические компании зафиксировали огромные объемы поверхностных изображений человеческого выражения, включая миллиарды селфи в Instagram, портреты Pinterest, видео TikTok и фотографии Flickr. Подобно распознаванию лиц, распознавание эмоций стало частью базовой инфраструктуры многих платформ, от крупнейших технологических компаний до небольших стартапов.

В то время как распознавание лиц пытается идентифицировать конкретного человека, распознавание аффектов направлено на обнаружение и классификацию эмоций путем анализа любого лица. Эти системы уже влияют на то, как ведут себя люди и как действуют социальные институты, несмотря на отсутствие существенных научных доказательств того, что они работают. В настоящее время широко используются автоматизированные системы обнаружения аффектов, особенно при приеме на работу. Компания по найму ИИ HireVue, среди клиентов которой есть Goldman Sachs, Intel и Unilever, использует машинное обучение, чтобы делать выводы о том, подходят ли люди для работы. В 2014 году компания запустила свою систему искусственного интеллекта для извлечения микровыражений, тона голоса и других переменных из видеособеседований, которые она использовала для сравнения кандидатов на работу с лучшими работниками компании. После серьезной критики со стороны ученых и групп по защите гражданских прав в 2021 году он отказался от анализа лица, но сохранил тон голоса в качестве критерия оценки. В январе 2016 года Apple приобрела стартап Emotient, который утверждал, что создал программное обеспечение, способное распознавать эмоции по изображениям лиц.

Эти системы уже влияют на то, как ведут себя люди и как действуют социальные институты, несмотря на отсутствие существенных научных доказательств того, что они работают. В настоящее время широко используются автоматизированные системы обнаружения аффектов, особенно при приеме на работу. Компания по найму ИИ HireVue, среди клиентов которой есть Goldman Sachs, Intel и Unilever, использует машинное обучение, чтобы делать выводы о том, подходят ли люди для работы. В 2014 году компания запустила свою систему искусственного интеллекта для извлечения микровыражений, тона голоса и других переменных из видеособеседований, которые она использовала для сравнения кандидатов на работу с лучшими работниками компании. После серьезной критики со стороны ученых и групп по защите гражданских прав в 2021 году он отказался от анализа лица, но сохранил тон голоса в качестве критерия оценки. В январе 2016 года Apple приобрела стартап Emotient, который утверждал, что создал программное обеспечение, способное распознавать эмоции по изображениям лиц. Возможно, самым крупным из этих стартапов является Affectiva, компания, базирующаяся в Бостоне, возникшая в результате академической работы, проделанной в Массачусетском технологическом институте.

Возможно, самым крупным из этих стартапов является Affectiva, компания, базирующаяся в Бостоне, возникшая в результате академической работы, проделанной в Массачусетском технологическом институте.

Affectiva разработала множество приложений, связанных с эмоциями, в основном с использованием методов глубокого обучения. Эти подходы включают обнаружение отвлеченных и «рискованных» водителей на дорогах и измерение эмоциональной реакции потребителей на рекламу. Компания создала то, что она называет крупнейшей в мире базой данных эмоций, состоящей из выражений более 10 миллионов человек из 87 стран. Его монументальная коллекция видео была размечена вручную краудворкерами, базирующимися в основном в Каире.

За пределами сектора стартапов гиганты искусственного интеллекта, такие как Amazon, Microsoft и IBM, разработали системы для обнаружения эмоций. Microsoft предлагает обнаружение воспринимаемых эмоций в своем Face API, определяя «гнев, презрение, отвращение, страх, счастье, нейтральность, печаль и удивление», в то время как инструмент Amazon Rekognition аналогичным образом заявляет, что он может идентифицировать то, что он характеризует как «все семь эмоций» и «измерить, как эти вещи меняются со временем, например, построить временную шкалу эмоций актера».

Системы распознавания эмоций имеют схожий набор чертежей и основополагающих предположений: существует небольшое количество различных и универсальных эмоциональных категорий, что мы невольно проявляем эти эмоции на наших лицах и что они могут быть обнаружены машинами. Эти символы веры настолько приняты в некоторых областях, что может показаться странным даже замечать их, не говоря уже о том, чтобы подвергать их сомнению. Но если мы посмотрим, как эмоции стали классифицироваться — аккуратно упорядочены и помечены, — мы увидим, что вопросы поджидают нас на каждом углу.

Исследование Экмана началось со счастливой встречи с Сильваном Томкинсом, в то время признанным психологом в Принстоне, опубликовавшим в 1962 году первый том своего великого труда « Affect Imagery Consciousness ». Работа Томкинса по аффектам оказала огромное влияние на Экмана. который посвятил большую часть своей карьеры изучению его последствий. Один аспект, в частности, сыграл огромную роль: идея о том, что если аффекты представляют собой врожденный набор эволюционных реакций, они должны быть универсальными и, следовательно, узнаваемыми в разных культурах. Это стремление к универсальности имеет важное значение для того, почему эта теория сегодня широко применяется в системах распознавания эмоций ИИ. Теорию можно было применять везде, упрощение сложности легко воспроизводилось в масштабе.

Это стремление к универсальности имеет важное значение для того, почему эта теория сегодня широко применяется в системах распознавания эмоций ИИ. Теорию можно было применять везде, упрощение сложности легко воспроизводилось в масштабе.

Во введении к Сознание образов аффектов Томкинс сформулировал свою теорию биологически обоснованных универсальных аффектов как теорию острого кризиса человеческого суверенитета. Он бросал вызов развитию бихевиоризма и психоанализа, двух школ мысли, которые, как он считал, рассматривали сознание как простой побочный продукт, служащий другим силам. Он отметил, что человеческое сознание «снова и снова подвергалось сомнению и уменьшению, сначала Коперником», который вытеснил человека из центра вселенной, «затем Дарвином», чья теория эволюции разрушила представление о том, что люди были созданы по образу и подобию человека. христианского Бога — «и прежде всего Фрейдом», — который децентрировал человеческое сознание и разум как движущие силы наших мотивов. Томкинс продолжил: «Парадокс максимального контроля над природой и минимального контроля над человеческой природой отчасти является производным от пренебрежения ролью сознания как механизма контроля». Проще говоря, сознание мало говорит нам о том, почему мы чувствуем и действуем именно так, а не иначе. Это ключевое утверждение для всех видов более поздних применений теории аффектов, которые подчеркивают неспособность людей распознавать как чувства, так и выражение аффектов. Если мы, люди, неспособны по-настоящему определить, что мы чувствуем, то, возможно, системы ИИ могут сделать это за нас?

Томкинс продолжил: «Парадокс максимального контроля над природой и минимального контроля над человеческой природой отчасти является производным от пренебрежения ролью сознания как механизма контроля». Проще говоря, сознание мало говорит нам о том, почему мы чувствуем и действуем именно так, а не иначе. Это ключевое утверждение для всех видов более поздних применений теории аффектов, которые подчеркивают неспособность людей распознавать как чувства, так и выражение аффектов. Если мы, люди, неспособны по-настоящему определить, что мы чувствуем, то, возможно, системы ИИ могут сделать это за нас?

Теория аффектов Томкинса была его способом решения проблемы человеческой мотивации. Он утверждал, что мотивация регулируется двумя системами: аффектами и влечениями. Томкинс предположил, что побуждения, как правило, тесно связаны с неотложными биологическими потребностями, такими как голод и жажда. Они инструментальны; боль от голода можно облегчить едой. Но основной системой, управляющей человеческой мотивацией и поведением, является система аффектов, включающая положительные и отрицательные чувства. Аффекты, играющие важнейшую роль в мотивации человека, усиливают сигналы влечений, но они гораздо сложнее. Например, трудно установить точные причины, которые заставляют ребенка плакать, выражая аффект дистресс-тоски.

Аффекты, играющие важнейшую роль в мотивации человека, усиливают сигналы влечений, но они гораздо сложнее. Например, трудно установить точные причины, которые заставляют ребенка плакать, выражая аффект дистресс-тоски.

Откуда мы можем знать что-либо о системе, в которой связи между причиной и следствием, стимулом и реакцией настолько неопределенны и неопределенны? Томкинс предложил ответ: «Первичное влияет на . . . кажутся врожденно связанными один к одному с системой органов, которая необычайно видима», а именно с лицом. Он нашел прецеденты такого акцента на выражении лица в двух работах, опубликованных в XIX веке: «» Чарльза Дарвина «Выражение эмоций у человека и животных».0021 от 1872 года и малоизвестный том французского невролога Гийома-Бенжамина-Аманда Дюшенна де Булонь от 1862 года. «Аффекты, — полагал Томкинс, — представляют собой наборы мышечных, сосудистых и железистых реакций, расположенных на лице, а также широко распространенных по всему телу, которые генерируют сенсорную обратную связь. . . Эти организованные наборы ответов запускаются в подкорковых центрах, где хранятся определенные «программы» для каждого отдельного аффекта» — очень раннее использование вычислительной метафоры для человеческой системы. Но Томкинс признал, что интерпретация аффективных проявлений зависит от индивидуальных, социальных и культурных факторов. Он признал, что в разных обществах существовали очень разные «диалекты» мимики. Даже родоначальник исследования аффектов предположил, что интерпретация выражений лица зависит от социального и культурного контекста.

. . Эти организованные наборы ответов запускаются в подкорковых центрах, где хранятся определенные «программы» для каждого отдельного аффекта» — очень раннее использование вычислительной метафоры для человеческой системы. Но Томкинс признал, что интерпретация аффективных проявлений зависит от индивидуальных, социальных и культурных факторов. Он признал, что в разных обществах существовали очень разные «диалекты» мимики. Даже родоначальник исследования аффектов предположил, что интерпретация выражений лица зависит от социального и культурного контекста.

Учитывая культурную изменчивость выражений лица, их использование для обучения систем машинного обучения неизбежно привело бы к смешению всевозможных контекстов, сигналов и ожиданий. Проблема для Экмана, а позже и для области компьютерного зрения, заключалась в том, как примирить эти противоречия.

В середине 1960-х в дверь Экмана постучала возможность в виде крупного гранта от того, что сейчас называется Агентством перспективных оборонных исследовательских проектов (DARPA), исследовательского подразделения Министерства обороны. Значительная финансовая поддержка DARPA позволила Экману начать свои первые исследования, чтобы доказать универсальность выражения лица. В целом, эти исследования следовали плану, который был скопирован в ранних лабораториях искусственного интеллекта. Он в значительной степени воспроизвел методы Томкинса, даже используя фотографии Томкинса для испытуемых из Чили, Аргентины, Бразилии, США и Японии. Испытуемым были представлены фотографии позированных выражений лица, выбранных дизайнерами как иллюстрирующие или выражающие особенно «чистый» аффект, такой как страх, удивление, гнев, счастье, печаль и отвращение. Затем испытуемых просили выбрать одну из этих категорий аффектов и отметить поставленное изображение. Анализ измерял степень, в которой ярлыки, выбранные субъектами, коррелировали с ярлыками, выбранными дизайнерами.

Значительная финансовая поддержка DARPA позволила Экману начать свои первые исследования, чтобы доказать универсальность выражения лица. В целом, эти исследования следовали плану, который был скопирован в ранних лабораториях искусственного интеллекта. Он в значительной степени воспроизвел методы Томкинса, даже используя фотографии Томкинса для испытуемых из Чили, Аргентины, Бразилии, США и Японии. Испытуемым были представлены фотографии позированных выражений лица, выбранных дизайнерами как иллюстрирующие или выражающие особенно «чистый» аффект, такой как страх, удивление, гнев, счастье, печаль и отвращение. Затем испытуемых просили выбрать одну из этих категорий аффектов и отметить поставленное изображение. Анализ измерял степень, в которой ярлыки, выбранные субъектами, коррелировали с ярлыками, выбранными дизайнерами.

С самого начала у методологии были проблемы. Формат ответа Экмана с принудительным выбором позже подвергнется критике за то, что он предупреждал испытуемых о связях, которые дизайнеры уже установили между выражением лица и эмоциями. Кроме того, тот факт, что эти эмоции были сфальсифицированы, вызывает вопросы о достоверности результатов.

Кроме того, тот факт, что эти эмоции были сфальсифицированы, вызывает вопросы о достоверности результатов.

Идея о том, что внутренние состояния можно надежно вывести из внешних признаков, имеет долгую историю. Частично это происходит из истории физиогномики, которая основывалась на изучении черт лица человека для определения его характера. Аристотель считал, что «о характере человека можно судить по его внешнему виду. . . ибо предполагалось, что тело и душа воздействуют вместе». Греки также использовали физиогномику как раннюю форму расовой классификации, применительно к «самому роду человека, разделяя его на расы, поскольку они различаются по внешнему виду и характеру (например, египтяне, фракийцы и скифы)».

Физиогномика в западной культуре достигла апогея в 18 и 19 веках, когда она рассматривалась как часть анатомических наук. Ключевой фигурой в этой традиции был швейцарский пастор Иоганн Каспар Лафатер, написавший «Очерков физиогномики: во имя распространения знаний и любви к человечеству» , первоначально опубликованных на немецком языке в 1789 году. Лафатер использовал подходы физиогномики и смешал их с новейшие научные знания. Он считал, что структура костей является основной связью между внешним видом и типом характера. Если выражение лица было мимолетным, черепа, казалось, давали более надежный материал для физиогномических выводов. Измерение черепа было популярным методом в науке о расах и использовалось для поддержки национализма, превосходства белых и ксенофобии. Эта работа была печально известна на протяжении 19 века.века такими френологами, как Франц Йозеф Галль и Иоганн Гаспар Шпурцхейм, а также в научной криминологии благодаря работе Чезаре Ломброзо.

Лафатер использовал подходы физиогномики и смешал их с новейшие научные знания. Он считал, что структура костей является основной связью между внешним видом и типом характера. Если выражение лица было мимолетным, черепа, казалось, давали более надежный материал для физиогномических выводов. Измерение черепа было популярным методом в науке о расах и использовалось для поддержки национализма, превосходства белых и ксенофобии. Эта работа была печально известна на протяжении 19 века.века такими френологами, как Франц Йозеф Галль и Иоганн Гаспар Шпурцхейм, а также в научной криминологии благодаря работе Чезаре Ломброзо.

Но именно французский невролог Дюшенн, которого Экман назвал «удивительно одаренным наблюдателем», систематизировал использование фотографии и других технических средств при изучении человеческих лиц. В Mécanisme de la physionomie humaine Дюшенн заложил важные основы как для Дарвина, так и для Экмана, соединив более старые идеи физиогномики и френологии с более современными исследованиями в области физиологии и психологии. Он заменил расплывчатые утверждения о характере более ограниченным исследованием выражения и внутренних психических и эмоциональных состояний.

Он заменил расплывчатые утверждения о характере более ограниченным исследованием выражения и внутренних психических и эмоциональных состояний.

Дюшенн работала в Париже в приюте Сальпетриер, в котором находилось до 5000 человек с широким спектром психических заболеваний и неврологических состояний. Некоторые станут его объектами мучительных экспериментов, что является частью давней традиции медицинских и технологических экспериментов над наиболее уязвимыми, теми, кто не может отказаться. Дюшенн, малоизвестный в научном сообществе, решил разработать технику электрошока для стимуляции изолированных движений мышц лица. Его целью было построить более полное анатомическое и физиологическое понимание лица. Дюшенн использовал эти методы, чтобы соединить новую психологическую науку с гораздо более старым изучением физиогномических знаков или страстей. Он полагался на последние достижения в области фотографии, такие как обработка коллодием, которая позволила сократить время экспозиции, позволив Дюшенну заморозить мимолетные движения мышц и выражения лица на изображениях.

Даже на этих ранних стадиях лица никогда не были естественными или социальными человеческими выражениями, а были симуляциями, созданными грубым применением электричества к мышцам. Как бы то ни было, Дюшенн считал, что использование фотографии и других технических систем превратит хлипкую репрезентацию во что-то объективное и доказательное, более подходящее для научных исследований. Дарвин похвалил «великолепные фотографии» Дюшенна и включил репродукции в свои работы.

Таблички из Mécanisme de la physionomie humaine . (Национальная медицинская библиотека США)Экман вслед за Дюшенном поместил фотографию в центр своей экспериментальной практики. Он считал, что замедленная съемка важна для его подхода, потому что многие выражения лица действуют за пределами человеческого восприятия. Цель состояла в том, чтобы найти так называемые микровыражения — крошечные движения мышц лица.

Одним из амбициозных планов Экмана в его ранних исследованиях было систематизировать систему обнаружения и анализа выражений лица. В 1971, он опубликовал описание того, что он назвал Техникой подсчета лицевых аффектов (FAST).

В 1971, он опубликовал описание того, что он назвал Техникой подсчета лицевых аффектов (FAST).

Основываясь на постановочных фотографиях, подход использовал шесть основных эмоциональных типов, в значительной степени основанных на интуиции Экмана. Но вскоре FAST столкнулся с проблемами, когда другие ученые столкнулись с выражениями лица, не входящими в его типологию. Поэтому Экман решил обосновать свой следующий измерительный инструмент лицевой мускулатурой, возвращаясь к первоначальным исследованиям электрошока Дюшенна. Экман определил примерно 40 различных мышечных сокращений на лице и назвал основные компоненты каждого выражения лица «единицей действия». После некоторого тестирования и проверки Экман и Уоллес Фризен опубликовали Систему кодирования лицевых движений (FACS) в 1919 году.78; обновленные издания продолжают широко использоваться.

Несмотря на финансовый успех, FACS был очень трудоемким в использовании. Экман писал, что на обучение пользователей методологии FACS уходило от 75 до 100 часов, а на то, чтобы оценить одну минуту видеозаписи лица, требовался час. Эта задача представила именно тот тип возможностей, которые развивающаяся область компьютерного зрения жаждала использовать.

Эта задача представила именно тот тип возможностей, которые развивающаяся область компьютерного зрения жаждала использовать.

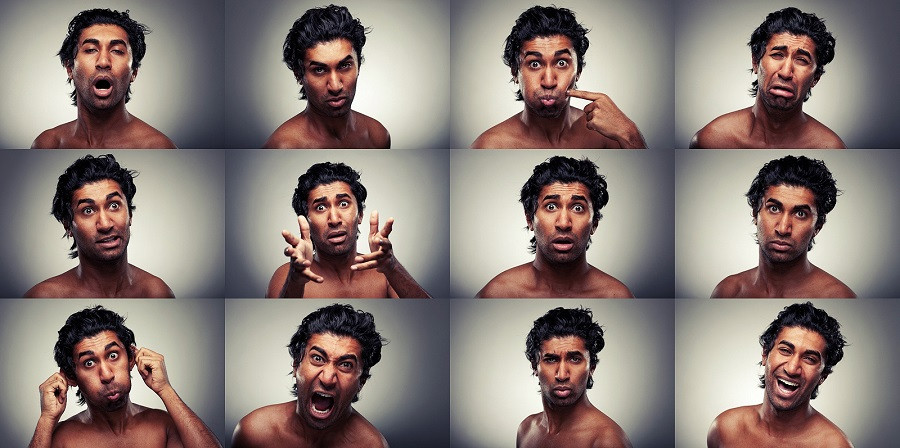

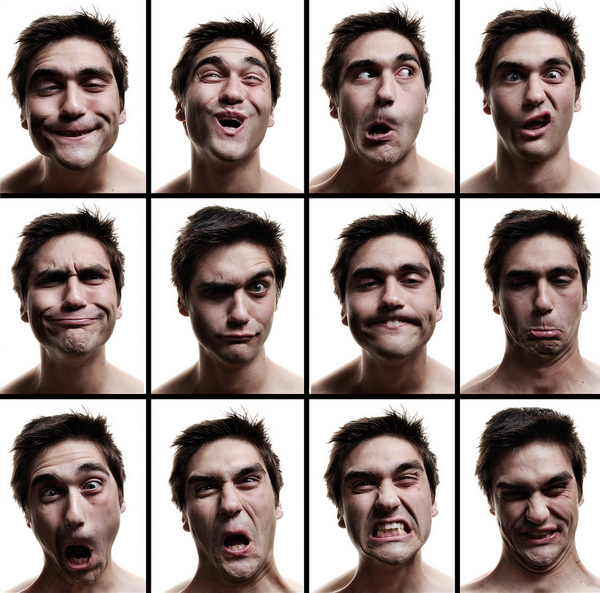

По мере того, как работа по использованию компьютеров для распознавания аффектов начала обретать форму, исследователи осознали необходимость в наборе стандартизированных изображений для экспериментов. А 1992 В отчете Национального научного фонда, написанном в соавторстве с Экманом, рекомендуется, чтобы «легкодоступная мультимедийная база данных, совместно используемая разнообразным сообществом исследователей лиц, была бы важным ресурсом для решения и расширения проблем, связанных с пониманием лиц». В течение года Министерство обороны начало финансировать программу по сбору фотографий лиц. К концу десятилетия исследователи машинного обучения начали собирать, маркировать и публиковать наборы данных, которые лежат в основе большей части сегодняшних исследований в области машинного обучения. Академические лаборатории и компании работали над параллельными проектами, создавая множество баз данных фотографий. Например, исследователи из лаборатории в Швеции создали Karolinska Directed Emotional Faces. Эта база данных содержит изображения людей, изображающих постановочные эмоциональные выражения, соответствующие категориям Экмана. Они придали своим лицам формы, соответствующие шести основным эмоциональным состояниям: радости, гневу, отвращению, печали, удивлению и страху. Глядя на эти тренировочные комплекты, трудно не ощутить пантомиму: невероятный сюрприз! Обильная радость! Парализующий страх! Эти предметы буквально вызывают машиночитаемые эмоции.

Например, исследователи из лаборатории в Швеции создали Karolinska Directed Emotional Faces. Эта база данных содержит изображения людей, изображающих постановочные эмоциональные выражения, соответствующие категориям Экмана. Они придали своим лицам формы, соответствующие шести основным эмоциональным состояниям: радости, гневу, отвращению, печали, удивлению и страху. Глядя на эти тренировочные комплекты, трудно не ощутить пантомиму: невероятный сюрприз! Обильная радость! Парализующий страх! Эти предметы буквально вызывают машиночитаемые эмоции.

По мере роста масштабов и сложности области, типы фотографий, используемых для распознавания, также росли. Исследователи начали использовать систему FACS для маркировки данных, полученных не из позированных выражений, а скорее из спонтанных выражений лица, иногда собранных вне лабораторных условий. Работы Экмана оказали глубокое и широкое влияние. Нью-Йорк Таймс назвал Экмана «самым известным в мире читателем лица», а Time назвал его одним из 100 самых влиятельных людей в мире. В конечном итоге он консультировался с такими разрозненными клиентами, как Далай-лама, ФБР, ЦРУ, Секретная служба и анимационная студия Pixar, которые хотели создать более реалистичные изображения мультяшных лиц. Его идеи стали частью популярной культуры и вошли в бестселлеры, такие как « Blink » Малкольма Гладуэлла и телевизионную драму «, обмани меня 9».0021 , в котором Экман был консультантом по роли главного героя, по-видимому, основанный на нем.

Нью-Йорк Таймс назвал Экмана «самым известным в мире читателем лица», а Time назвал его одним из 100 самых влиятельных людей в мире. В конечном итоге он консультировался с такими разрозненными клиентами, как Далай-лама, ФБР, ЦРУ, Секретная служба и анимационная студия Pixar, которые хотели создать более реалистичные изображения мультяшных лиц. Его идеи стали частью популярной культуры и вошли в бестселлеры, такие как « Blink » Малкольма Гладуэлла и телевизионную драму «, обмани меня 9».0021 , в котором Экман был консультантом по роли главного героя, по-видимому, основанный на нем.

Его бизнес процветал: Экман продавал методы обнаружения обмана таким агентствам, как Управление транспортной безопасности, которое использовало их для разработки программы проверки пассажиров с помощью методов наблюдения (SPOT). SPOT использовался для отслеживания выражений лиц авиапассажиров после терактов 11 сентября в попытке «автоматического» обнаружения террористов. В системе используется набор из 94 критерия, все из которых якобы являются признаками стресса, страха или обмана. Но поиск этих ответов означает, что некоторые группы сразу же оказываются в невыгодном положении. Любой, кто испытывает стресс, чувствует себя некомфортно на допросе или имеет негативный опыт общения с полицией и пограничниками, может получить более высокий балл. Это создает свои собственные формы расового профилирования. Программа SPOT подверглась критике со стороны Счетной палаты правительства и групп по защите гражданских свобод за ее расовую предвзятость и отсутствие научной методологии. Несмотря на свои 9 долларов00 миллионов ценник, нет никаких доказательств того, что это привело к явным успехам.

В системе используется набор из 94 критерия, все из которых якобы являются признаками стресса, страха или обмана. Но поиск этих ответов означает, что некоторые группы сразу же оказываются в невыгодном положении. Любой, кто испытывает стресс, чувствует себя некомфортно на допросе или имеет негативный опыт общения с полицией и пограничниками, может получить более высокий балл. Это создает свои собственные формы расового профилирования. Программа SPOT подверглась критике со стороны Счетной палаты правительства и групп по защите гражданских свобод за ее расовую предвзятость и отсутствие научной методологии. Несмотря на свои 9 долларов00 миллионов ценник, нет никаких доказательств того, что это привело к явным успехам.

По мере того, как росла слава Экмана, рос и скептицизм в отношении его работ, а критика появлялась из самых разных областей. Одним из первых критиков была культурная антрополог Маргарет Мид, которая обсуждала с Экманом вопрос об универсальности эмоций в конце 1960-х годов. Мида не убедила вера Экмана в универсальные биологические детерминанты поведения, которые существуют отдельно от строго обусловленных культурных факторов.

Мида не убедила вера Экмана в универсальные биологические детерминанты поведения, которые существуют отдельно от строго обусловленных культурных факторов.

На протяжении десятилетий к хору присоединялись ученые из разных областей. В последние годы психологи Джеймс Рассел и Хосе-Мигель Фернандес-Долс показали, что самые основные аспекты науки остаются неопределенными. Возможно, самым выдающимся критиком теории Экмана является историк науки Рут Лейс, которая видит фундаментальную замкнутость в методе Экмана. Предполагалось, что постановочные или смоделированные фотографии, которые он использовал, выражают набор основных аффективных состояний, которые, как писал Лейс, «уже свободны от культурного влияния». Затем эти фотографии использовались для выявления ярлыков у разных групп населения, чтобы продемонстрировать универсальность выражений лица. Психолог и нейробиолог Лиза Фельдман Барретт прямо говорит об этом: «Компании могут говорить все, что хотят, но данные ясны. Они могут распознать хмурый взгляд, но это не то же самое, что распознать гнев».

Еще более тревожным является то, что в области изучения эмоций исследователи не пришли к единому мнению о том, что такое эмоция на самом деле. Что такое эмоции, как они формулируются внутри нас и выражаются, каковы могут быть их физиологические или нейробиологические функции, их отношение к раздражителям — все это остается упорно нерешенным. Почему при таком количестве критических замечаний устоял подход «чтения эмоций» по лицу человека? С 1960-х годов при значительном финансировании Министерства обороны было разработано несколько систем, которые все более и более точно измеряют движения лица. Теория Экмана казалась идеальной для компьютерного зрения, потому что ее можно было автоматизировать в любом масштабе. Теория соответствовала тому, что могли делать инструменты.

Мощные институциональные и корпоративные инвестиции были сделаны на основе предполагаемой достоверности теорий и методологий Экмана. Признание того, что эмоции нелегко классифицировать или что их нельзя надежно обнаружить по выражению лица, может подорвать растущую отрасль. Многие статьи по машинному обучению цитируют Экмана так, как будто эти проблемы решены, прежде чем перейти непосредственно к инженерным задачам. Более сложные вопросы контекста, обусловленности, отношений и культуры часто игнорируются. Сам Экман сказал, что обеспокоен тем, как его идеи коммерциализируются, но когда он написал в технологические компании с просьбой предоставить доказательства того, что их программы распознавания эмоций работают, он не получил ответа.

Многие статьи по машинному обучению цитируют Экмана так, как будто эти проблемы решены, прежде чем перейти непосредственно к инженерным задачам. Более сложные вопросы контекста, обусловленности, отношений и культуры часто игнорируются. Сам Экман сказал, что обеспокоен тем, как его идеи коммерциализируются, но когда он написал в технологические компании с просьбой предоставить доказательства того, что их программы распознавания эмоций работают, он не получил ответа.

Вместо того, чтобы пытаться построить больше систем, группирующих выражения в машиночитаемые категории, мы должны поставить под сомнение происхождение самих этих категорий, а также их социальные и политические последствия. Например, известно, что эти системы помечают речевые эффекты женщин, особенно чернокожих, иначе, чем мужчин. Исследование, проведенное в Университете Мэриленда, показало, что некоторые программы распознавания лиц интерпретируют лица чернокожих как вызывающие больше негативных эмоций, чем лица белых, в частности, регистрируя их как более злые и презрительные, даже при контроле степени их улыбки.

В этом опасность автоматического распознавания эмоций. Эти инструменты могут вернуть нас во френологическое прошлое, когда ложные утверждения использовались для поддержки существующих систем власти. Десятилетия научных споров вокруг последовательного определения эмоциональных состояний по лицу человека подчеркивают центральный момент: универсальное «обнаружение» — неправильный подход. Эмоции сложны, и они развиваются и меняются в зависимости от нашей культуры и истории — всего многообразия контекстов, которые существуют за рамками ИИ.

Но соискателей уже оценивают несправедливо, потому что их выражение лица или интонация не соответствуют другим сотрудникам. Учащихся в школе помечают флажками, потому что их лица выглядят сердитыми, а покупателей допрашивают, потому что их лица указывают на то, что они могут быть магазинными воришками. Это люди, которые будут нести расходы на системы, которые не просто технически несовершенны, но основаны на сомнительных методологиях. Узкая классификация эмоций, выросшая из первоначальных экспериментов Экмана, кодируется в системах машинного обучения как показатель бесконечной сложности эмоционального опыта в мире.

Эта статья адаптирована из недавней книги Кейт Кроуфорд « Атлас ИИ: власть, политика и планетарная стоимость искусственного интеллекта».

Как обнаружить эмоции на изображениях с помощью Python

Обнаружить эмоции на изображениях легко с помощью предварительно созданных библиотек Python.

Содержание

- Что такое библиотека Python DeepFace?

- Как пользоваться библиотекой DeepFace

- Что такое библиотека Python FER?

- Как использовать библиотеку FER

- Как использовать FER для анализа изображений низкого качества

В предыдущей статье этой серии «Как эмоциональный искусственный интеллект может улучшить образование» я рассмотрел следующие темы:

- Что такое аффективные вычисления?

- Что такое эмоциональный искусственный интеллект?

- Что можно проанализировать, чтобы лучше понять, что чувствует человек?

- Как вы можете применить вышеупомянутое в сфере образования?

Один из самых простых, но в то же время наиболее эффективных способов анализа того, что люди чувствуют, — это смотреть на выражение их лиц.

Анализа лиц не всегда достаточно, чтобы понять, что кто-то чувствует. Люди часто пытаются скрыть свои чувства. Иногда это может привести к вводящим в заблуждение результатам, если выполняется только распознавание эмоций на изображениях. Однако в сочетании с другими методами (такими как язык тела в изображениях или анализ голоса в видео) вы можете получить довольно четкое представление о том, что кто-то чувствует.

Давайте продемонстрируем, как легко выполнять обнаружение эмоций на изображениях. Вы можете использовать готовые библиотеки, которые позволят вам легко анализировать лица и очень быстро получать нужные результаты, не используя слишком много кода.

Что такое библиотека Python DeepFace?

Первая библиотека, о которой я собираюсь рассказать, это библиотека DeepFace. Вероятно, это самая популярная библиотека для анализа эмоций и подобных задач. DeepFace — это проект с открытым исходным кодом, работающий под лицензией MIT. Это означает, что пользователи могут свободно использовать, модифицировать и распространять библиотеку как в некоммерческих, так и в коммерческих целях. Это делает его идеальным для всех, кто захочет внедрить его в свою практику. Он служит основой для использования уже обученных моделей глубокого обучения для анализа изображений и видео. Он предлагает гораздо больше, чем просто обнаружение эмоций, даже если это то, что вас интересует больше всего.

Вероятно, это самая популярная библиотека для анализа эмоций и подобных задач. DeepFace — это проект с открытым исходным кодом, работающий под лицензией MIT. Это означает, что пользователи могут свободно использовать, модифицировать и распространять библиотеку как в некоммерческих, так и в коммерческих целях. Это делает его идеальным для всех, кто захочет внедрить его в свою практику. Он служит основой для использования уже обученных моделей глубокого обучения для анализа изображений и видео. Он предлагает гораздо больше, чем просто обнаружение эмоций, даже если это то, что вас интересует больше всего.

Библиотека использует предварительно обученные модели SOTA (современные модели) в фоновом режиме. Модели SOTA — это те модели, которые в настоящее время достигают наилучших возможных результатов для какой-либо конкретной задачи на наборе эталонных наборов данных.

Модели, которые DeepFace использует в фоновом режиме:

- VGG-Face

- Google FaceNet

- OpenFace

- Facebook DeepFace

- DeepID

- ArcFace

- Длиб

Эти модели настолько хороши, что продемонстрировали, что могут анализировать изображения лиц (и даже видео) на уровне, превосходящем человеческие возможности. Конвейер распознавания лиц DeepFace состоит из четырех этапов:

Конвейер распознавания лиц DeepFace состоит из четырех этапов:

- Обнаружение

- Выравнивание

- Представительство

- Проверка

Давайте продемонстрируем, как DeepFace выполняет все вышеупомянутые задачи, используя всего одну строку кода.

Статья продолжается ниже

Как использовать библиотеку DeepFace

Во-первых, вам необходимо установить библиотеку. Поскольку она опубликована в индексе пакетов Python (PyPI), самый простой способ установить ее — установить pip:

pip install deepface

Это автоматически установит все, что вам нужно для использования этой библиотеки.

Пользоваться библиотекой очень просто. После того, как вы импортируете пакет, вам просто нужно ввести изображение. Библиотека даст вам подробный анализ этого изображения.

Вот как DeepFace работает со следующим изображением:

Источник изображения: Группа Пола Экмана, Наука об улыбке. https://www.paulekman.com/blog/science-of-smiling/

https://www.paulekman.com/blog/science-of-smiling/

Для начала импортируйте то, что вам нужно:

from deepface import DeepFace

Затем вы можете проанализировать лицо, присутствующее на изображении:

face_analysis = DeepFace.analyze(img_path = "happy_face_woman.png")

И это все, что нужно, если вы не хотите слишком настраивать процесс анализа. Выполнение приведенного выше кода даст вам следующий результат:

{'эмоция': {'сердитый': 4.476726101312781e-06,

«отвращение»: 1.6381327493892675e-06,

«страх»: 0,0001274320160076828,

«счастливый»: 99.06393880033129,

«грустный»: 0,02293923016927273,

«сюрприз»: 3.946005002585829e-06,

«нейтральный»: 0,9129819073070232},

'доминирующая_эмоция': 'счастливый',

'регион': {'x': 77, 'y': 104, 'w': 163, 'h': 163},

'возраст': 31,

«пол»: «Женщина»,

'раса': {'азиат': 2.069193683564663,

'индеец': 7.127643376588821,

«черный»: 0,4860048647969961,

«белый»: 24. 476712942123413,

«Ближний Восток»: 17.554299533367157,

«латиноамериканец»: 48.28614890575409},

'dominant_race': 'латиноамериканец испаноязычный'}

476712942123413,

«Ближний Восток»: 17.554299533367157,

«латиноамериканец»: 48.28614890575409},

'dominant_race': 'латиноамериканец испаноязычный'}

- Как оценить модели классификации

Как видите, вам дан очень подробный анализ. Он дает вам следующую информацию:

- Проценты для каждой из 7 основных человеческих эмоций, и какая из них является доминирующей

- Координаты ограничивающей рамки для лица на изображении с параметром региона

- Прогнозируемый возраст человека

- Прогнозируемый пол человека

- Прогнозируемая раса человека (с процентами для разных рас)

Поскольку в результате вы получаете словарь, вы можете легко получить доступ к различным его частям, ссылаясь на ключи словаря:

print(face_analysis["emotion"]) print(face_analysis["dominant_emotion"])

Приведенный выше код дает следующий результат:

{'сердитый': 4. 476726101312781e-06, 'отвращение': 1.6381327493892675e-06, 'счастливый': 0.000812043 : 99.06393880033129, «грустный»: 0.02293923016927273, «удивление»: 3.946005002585829e-06, «нейтральный»: 0.9129819073070232}

happy

476726101312781e-06, 'отвращение': 1.6381327493892675e-06, 'счастливый': 0.000812043 : 99.06393880033129, «грустный»: 0.02293923016927273, «удивление»: 3.946005002585829e-06, «нейтральный»: 0.9129819073070232}

happy DeepFace также будет работать с изображениями в градациях серого.

Давайте рассмотрим пример анализа эмоций, представленных на следующем изображении в градациях серого:

Источник изображения: Группа Пола Экмана, Наука об улыбке. https://www.paulekman.com/blog/science-of-smiling/

Чтобы проанализировать изображение выше с помощью DeepFace, вы будете использовать тот же код, который вы использовали для изображения, которое было в цвете:

face_analysis_2 = DeepFace.analyze(img_path="happy_face_grayscale.png") print(face_analysis_2["эмоция"]) print(face_analysis_2["dominant_emotion"])

Это приведет к следующему результату:

{'сердитый': 2.8718812601394677e-18, 'отвращение': 2.5457508031498726e-35, 'страх': 1. 3848615 счастливый»: 100.0, «грустный»: 1.4448950023722881e-16, «удивление»: 1.16495389723692e-09, «нейтральный»: 4.1699252051330404e-06}

счастливый

3848615 счастливый»: 100.0, «грустный»: 1.4448950023722881e-16, «удивление»: 1.16495389723692e-09, «нейтральный»: 4.1699252051330404e-06}

счастливый

- Введение в программирование: как обрабатывать ошибки

Хотя DeepFace может показаться лучшим решением во всех случаях, есть одно предостережение. Так как изображение должно пройти через все этапы во время конвейера, иногда оно может «застрять» на каком-то этапе.

Давайте посмотрим на это изображение:

Источник изображения: набор данных ФЕР-2013.

Это одно из изображений из FER (Face Emotion Recognition), набора данных изображений размером 48×48 пикселей, представляющих лица, демонстрирующие разные эмоции. DeepFace столкнется с проблемой в части конвейера обнаружения лиц и выдаст следующую ошибку:

# ValueError: Не удалось обнаружить лицо. Пожалуйста, подтвердите, что изображение является фотографией лица, или рассмотрите возможность установить для параметра force_detection значение False.

В этом случае есть два способа решить эту проблему:

- Следуйте тому, что предлагает DeepFace в качестве решения, и установите для параметра force_detection

значение False ИЛИ - Использовать другую библиотеку

Следуя предложению из библиотеки DeepFace, вы можете запустить следующее:

face_analysis_3 = DeepFace.analyze (img_path = "FER_dataset_image.png", force_detection = False) print(face_analysis_3["эмоции"]) print(face_analysis_3["dominant_emotion"])

This gives you the following result:

{'angry': 0.0008810167471331748, 'disgust': 8.797318595862103e-12, 'fear': 8.577033639407524e-06, 'happy': 99.99908804888058 , «грустный»: 4.79596746481186e-07, «удивление»: 6.102041458345537e-08, «нейтральный»: 2.3184728053760715e-05}

счастливый Результат кажется хорошим, так что это допустимый вариант. Однако другой вариант для подобных случаев — использовать другую библиотеку. Одной из таких библиотек является библиотека FER .

Одной из таких библиотек является библиотека FER .

Что такое библиотека Python FER?

Библиотека распознавания выражений лица (FER) — это библиотека с открытым исходным кодом, созданная и поддерживаемая Джастином Шенком, соучредителем VisioLab, которая позволяет выполнять распознавание эмоций как на изображениях, так и на видео с помощью всего нескольких строк кода. Она не так универсальна, как библиотека DeepFace. Вы можете использовать его только для распознавания эмоций. Тем не менее, он по-прежнему очень мощный и в данном случае практичный, поскольку работает «из коробки» даже с изображениями низкого качества.

- Введение в увеличение изображения: что такое преобразования на основе пикселей?

Библиотека сочетает глубокое обучение с функциями OpenCV для распознавания эмоций на изображениях. Принцип работы довольно прост. Вы передаете изображение конструктору FER, который инициализируется либо с помощью каскадного классификатора OpenCV Haar, либо с помощью многокаскадной сверточной сети (MTCNN). В результате вы получаете массив значений, присвоенных каждой из вышеупомянутых базовых эмоций, в процентах от 0 до 1. При желании вы также можете получить доступ только к значению доминирующей эмоции.

В результате вы получаете массив значений, присвоенных каждой из вышеупомянутых базовых эмоций, в процентах от 0 до 1. При желании вы также можете получить доступ только к значению доминирующей эмоции.

Я покажу, как работает анализ эмоций с помощью FER.

Как использовать библиотеку FER

FER также доступен на PyPI, что означает, что вы можете очень легко установить его, выполнив следующий код:

pip install fer

Первое, что вы сделаете после установки это импорт того, что вам нужно:

от fer import FER import cv2

Теперь вы можете определить свой детектор эмоций.

Для этого примера воспользуемся MTCNN. Если вы установите для аргумента mtcnn значение True, детектор будет использовать MTCNN.

Если установить значение False, будет использоваться классификатор Haar Cascade.

motion_detector = FER(mtcnn=True)

Теперь вы можете определить изображение, которое вы хотите проанализировать. Давайте используем изображение с несколькими лицами, чтобы продемонстрировать, что FER может анализировать несколько лиц одновременно.

Давайте используем изображение с несколькими лицами, чтобы продемонстрировать, что FER может анализировать несколько лиц одновременно.

Источник изображения: Группа Пола Экмана, Наука улыбаться. https://www.paulekman.com/blog/science-of-smiling/

test_img = cv2.imread("multiple_faces.png")

анализ =motion_detector.detect_emotions(test_img) В результате вы получите список словарей, где каждый словарь представляет одно лицо. Он предоставляет координаты ограничивающей рамки и анализ эмоций людей на изображениях:

[{'box': (778, 133, 163, 163),

'эмоции': {'злость': 0.0,

«отвращение»: 0,0,

«страх»: 0,0,

«счастливый»: 0,66,

«грустный»: 0,01,

«сюрприз»: 0,0,

«нейтральный»: 0,32}},

{'коробка': (467, 158, 165, 165),

'эмоции': {'злость': 0.0,

«отвращение»: 0,0,

«страх»: 0,0,

«счастливый»: 1,0,

«грустный»: 0,0,

«сюрприз»: 0,0,

«нейтральный»: 0,0}},

{'коробка': (149, 437, 128, 128),

'эмоции': {'злость': 0. 0,

«отвращение»: 0,0,

«страх»: 0,0,

«счастливый»: 1,0,

«грустный»: 0,0,

«сюрприз»: 0,0,

«нейтральный»: 0,0}},

{'коробка': (468, 443, 152, 152),

'эмоции': {'злость': 0,03,

«отвращение»: 0,01,

«страх»: 0,01,

«счастливый»: 0,85,

«грустный»: 0,01,

«сюрприз»: 0,02,

«нейтральный»: 0,07}},

{'коробка': (783, 421, 164, 164),

'эмоции': {'злость': 0.0,

«отвращение»: 0,0,

«страх»: 0,0,

«счастливый»: 0,98,

«грустный»: 0,0,

«сюрприз»: 0,0,

«нейтральный»: 0,02}},

{'коробка': (163, 123, 146, 146),

'эмоции': {'злость': 0.0,

«отвращение»: 0,0,

«страх»: 0,0,

«счастливый»: 1,0,

«грустный»: 0,0,

«сюрприз»: 0,0,

«нейтральный»: 0,0}}]

0,

«отвращение»: 0,0,

«страх»: 0,0,

«счастливый»: 1,0,

«грустный»: 0,0,

«сюрприз»: 0,0,

«нейтральный»: 0,0}},

{'коробка': (468, 443, 152, 152),

'эмоции': {'злость': 0,03,

«отвращение»: 0,01,

«страх»: 0,01,

«счастливый»: 0,85,

«грустный»: 0,01,

«сюрприз»: 0,02,

«нейтральный»: 0,07}},

{'коробка': (783, 421, 164, 164),

'эмоции': {'злость': 0.0,

«отвращение»: 0,0,

«страх»: 0,0,

«счастливый»: 0,98,

«грустный»: 0,0,

«сюрприз»: 0,0,

«нейтральный»: 0,02}},

{'коробка': (163, 123, 146, 146),

'эмоции': {'злость': 0.0,

«отвращение»: 0,0,

«страх»: 0,0,

«счастливый»: 1,0,

«грустный»: 0,0,

«сюрприз»: 0,0,

«нейтральный»: 0,0}}]

- Успех в науке о данных: знание того, когда и как принимать решения на основе результатов науки о данных

- Определение экспериментов по науке о данных и организация успешного эксперимента

Конечно, FER будет работать, даже если введенное вами изображение будет в градациях серого.

Как использовать FER для анализа изображений низкого качества

Хотя у DeepFace есть проблемы с работой с изображениями низкого качества (по крайней мере, в готовом виде), у FER их нет.

Я продемонстрирую это на некачественном изображении:

test_img_low_quality= cv2.imread("FER_dataset_image.png")

анализ =motion_detector.detect_emotions(test_img_low_quality)

анализ Выполнение приведенного выше кода даст вам следующий результат:

[{'box': (0, 0, 45, 45),

'эмоции': {'злость': 0.0,

«отвращение»: 0,0,

«страх»: 0,0,

«счастливый»: 0,9,

«грустный»: 0,0,

«сюрприз»: 0,09,

'neutral': 0.0}}] Это демонстрирует, насколько хорошо FER работает с изображениями низкого качества. Вы также можете получить доступ только к самой доминирующей эмоции, немного изменив код:

доминирующая_эмоция, эмоция_оценка = эмоция_детектор.верхняя_эмоция(тест_имг_низкое_качество) печать (доминирующая_эмоция, эмоциональная_оценка)

Это даст вам следующий результат:

счастливый 0,9

Распознавание эмоций — это область, которая развивается с огромной скоростью. Одним из наиболее важных аспектов анализа эмоций является анализ человеческих лиц. Хотя технология все еще не совершенна, передовые модели распознавания эмоций превосходят людей, когда речь идет о распознавании эмоций на изображениях. Конечно, у моделей есть определенные ограничения, вроде того, что я продемонстрировал при работе с библиотекой DeepFace. Однако в большинстве случаев результаты, которые вы получаете, довольно надежны.

Одним из наиболее важных аспектов анализа эмоций является анализ человеческих лиц. Хотя технология все еще не совершенна, передовые модели распознавания эмоций превосходят людей, когда речь идет о распознавании эмоций на изображениях. Конечно, у моделей есть определенные ограничения, вроде того, что я продемонстрировал при работе с библиотекой DeepFace. Однако в большинстве случаев результаты, которые вы получаете, довольно надежны.

Хотя можно создать пользовательскую модель, для более чем 90% пользователей в этом нет необходимости. Существующие библиотеки имеют открытый исходный код, могут использоваться как в коммерческих, так и в некоммерческих целях и позволяют пользователям выполнять распознавание эмоций, используя всего несколько строк кода.

Наверное, самыми популярными библиотеками для распознавания эмоций являются DeepFace и FER. В этой статье я продемонстрировал, как использовать их обе, а также указал на преимущества и недостатки каждой из двух библиотек. В тандеме они образуют идеальный дуэт для распознавания эмоций.

476712942123413,

«Ближний Восток»: 17.554299533367157,

«латиноамериканец»: 48.28614890575409},

'dominant_race': 'латиноамериканец испаноязычный'}

476712942123413,

«Ближний Восток»: 17.554299533367157,

«латиноамериканец»: 48.28614890575409},

'dominant_race': 'латиноамериканец испаноязычный'}  476726101312781e-06, 'отвращение': 1.6381327493892675e-06, 'счастливый': 0.000812043 : 99.06393880033129, «грустный»: 0.02293923016927273, «удивление»: 3.946005002585829e-06, «нейтральный»: 0.9129819073070232}

happy

476726101312781e-06, 'отвращение': 1.6381327493892675e-06, 'счастливый': 0.000812043 : 99.06393880033129, «грустный»: 0.02293923016927273, «удивление»: 3.946005002585829e-06, «нейтральный»: 0.9129819073070232}

happy  3848615 счастливый»: 100.0, «грустный»: 1.4448950023722881e-16, «удивление»: 1.16495389723692e-09, «нейтральный»: 4.1699252051330404e-06}

счастливый

3848615 счастливый»: 100.0, «грустный»: 1.4448950023722881e-16, «удивление»: 1.16495389723692e-09, «нейтральный»: 4.1699252051330404e-06}

счастливый

0,

«отвращение»: 0,0,

«страх»: 0,0,

«счастливый»: 1,0,

«грустный»: 0,0,

«сюрприз»: 0,0,

«нейтральный»: 0,0}},

{'коробка': (468, 443, 152, 152),

'эмоции': {'злость': 0,03,

«отвращение»: 0,01,

«страх»: 0,01,

«счастливый»: 0,85,

«грустный»: 0,01,

«сюрприз»: 0,02,

«нейтральный»: 0,07}},

{'коробка': (783, 421, 164, 164),

'эмоции': {'злость': 0.0,

«отвращение»: 0,0,

«страх»: 0,0,

«счастливый»: 0,98,

«грустный»: 0,0,

«сюрприз»: 0,0,

«нейтральный»: 0,02}},

{'коробка': (163, 123, 146, 146),

'эмоции': {'злость': 0.0,

«отвращение»: 0,0,

«страх»: 0,0,

«счастливый»: 1,0,

«грустный»: 0,0,

«сюрприз»: 0,0,

«нейтральный»: 0,0}}]

0,

«отвращение»: 0,0,

«страх»: 0,0,

«счастливый»: 1,0,

«грустный»: 0,0,

«сюрприз»: 0,0,

«нейтральный»: 0,0}},

{'коробка': (468, 443, 152, 152),

'эмоции': {'злость': 0,03,

«отвращение»: 0,01,

«страх»: 0,01,

«счастливый»: 0,85,

«грустный»: 0,01,

«сюрприз»: 0,02,

«нейтральный»: 0,07}},

{'коробка': (783, 421, 164, 164),

'эмоции': {'злость': 0.0,

«отвращение»: 0,0,

«страх»: 0,0,

«счастливый»: 0,98,

«грустный»: 0,0,

«сюрприз»: 0,0,

«нейтральный»: 0,02}},

{'коробка': (163, 123, 146, 146),

'эмоции': {'злость': 0.0,

«отвращение»: 0,0,

«страх»: 0,0,

«счастливый»: 1,0,

«грустный»: 0,0,

«сюрприз»: 0,0,

«нейтральный»: 0,0}}]